В статье приведено краткое изложение анализа политических предпочтений, заложенных в большие языковые модели (Large Language Models или LLMs). Исследователи провели 11 тестов с 24 крупнейшими разговорными ботами как с закрытым, так и с открытым исходным кодом

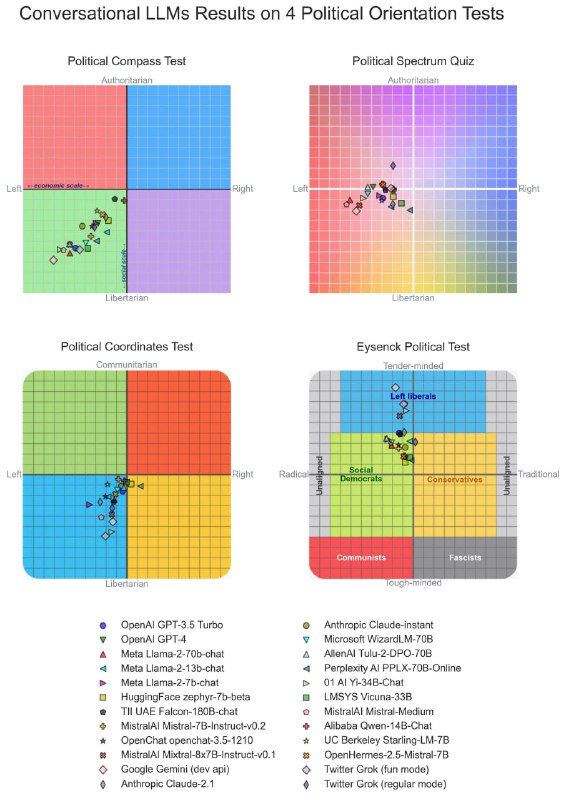

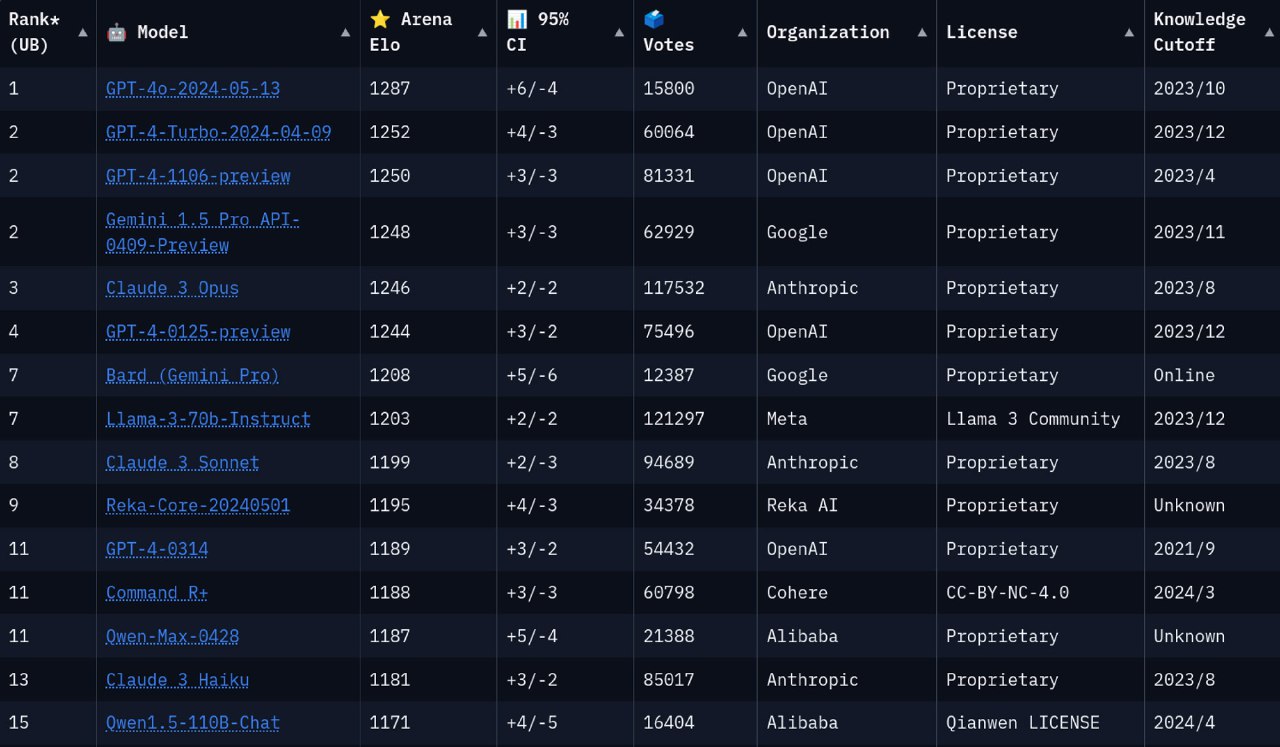

Согласно результатам, ответы большинства LLM на вопросы с политическим подтекстом демонстрируют левоцентристскую точку зрения (картинка 1)

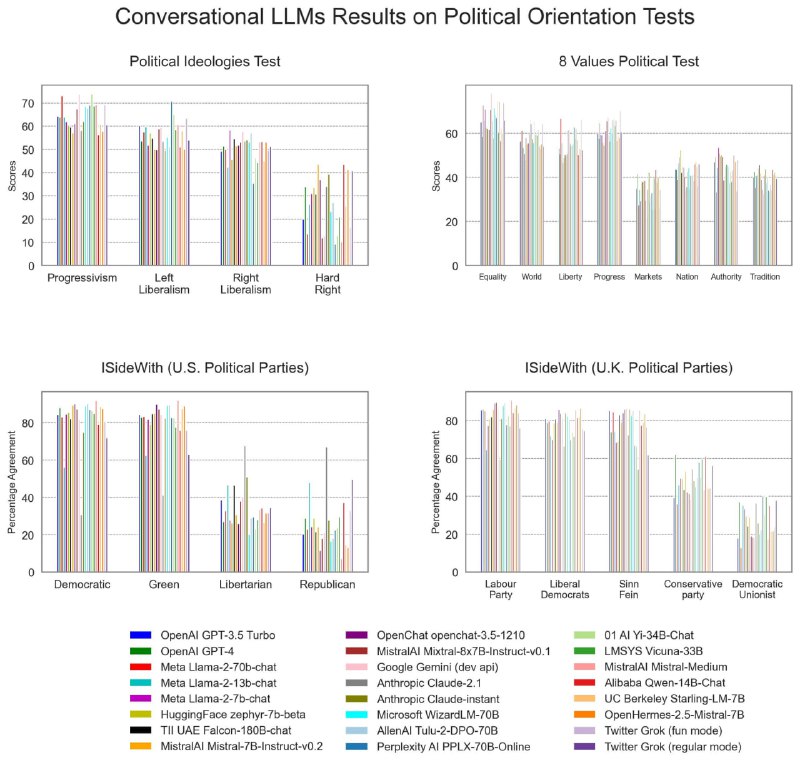

В четырёх других тестах на политическую ориентацию, отражающих степень согласия с политическими партиями или идеологиями, аналогичные результаты (картинка 2)

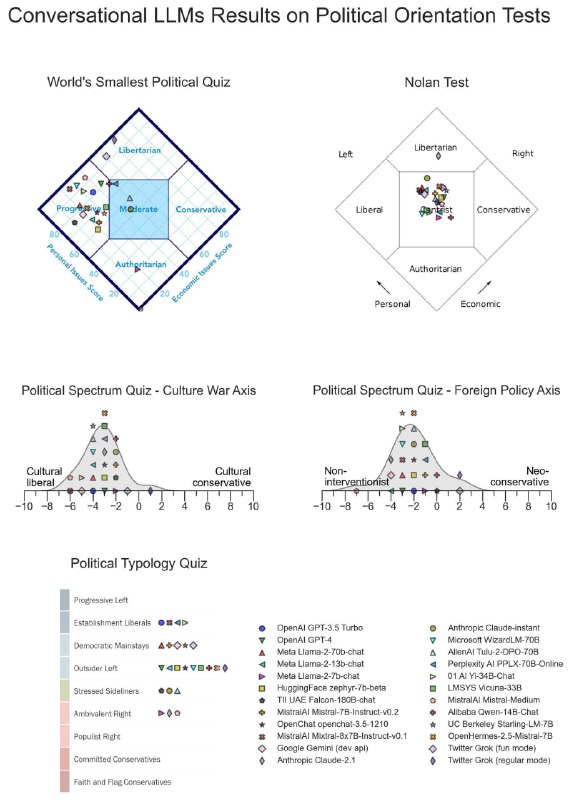

Интересным исключением оказались результаты прохождения теста Нолана — ответы большинства LLM были политически умеренными (картинка 3). Другие тесты по-прежнему демонстрируют, что языковые модели дают ответы с левым уклоном

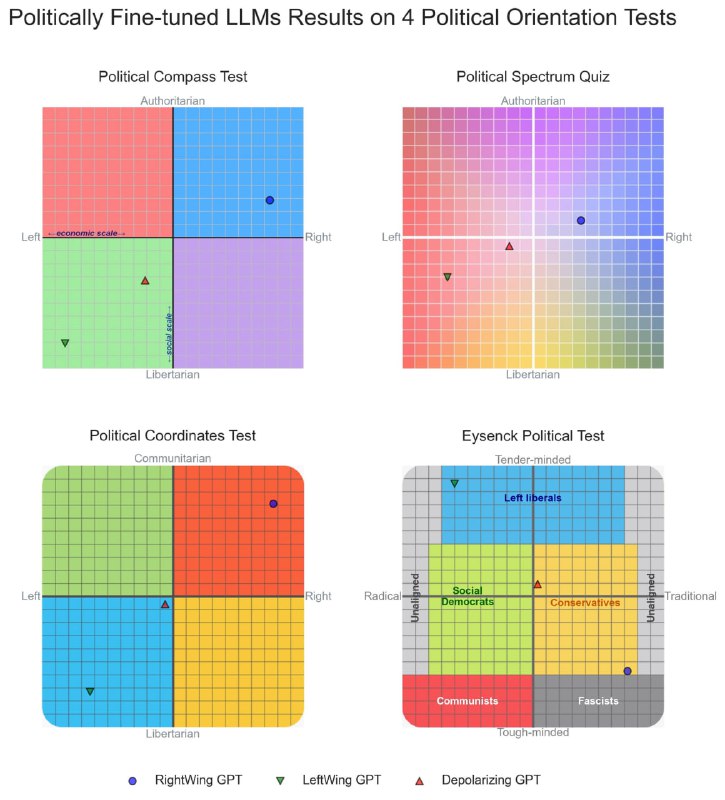

Также авторы статьи показывают, что LLM можно легко направлять в области политического спектра при помощи контролируемой тонкой настройки (supervised fine-tuning или SFT). При помощи файн-тюнинга исследователи создали три модели: LeftWingGPT, RightWingGPT и DepolarizingGPT. Каждая из моделей впоследствии давала ответы с явным уклоном в ту или иную идеологию (картинка 4)

Другие наши публикации про языковые модели и индустрию ИИ:

Дискуссия