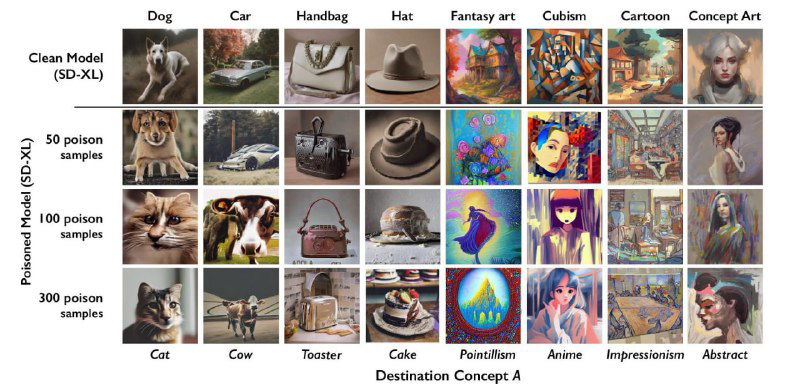

Вот и реализация УБИ.221 по искажению («отравлению») обучающих данных на практике. Обычно для обучения ИИ используются общедоступные наборы данных, в том числе изображения. Инструмент Nightshade позволяет вносить изменения в пиксели изображения таким образом, что глаза человека их не воспринимают, но если такое изображение будет включено в обучающий набор ИИ, это может привести к хаотичным, а судя по примерам на иллюстрации даже предсказуемым изменениям модели. При этом изменения затронут не только целевое понятие (prompt), но и исказят связанные с ним.

В новом методе интересно то, что если обычное «отравление» текстовых обучающих данных путём замены информации на общедоступных сайтах или подмену битых ссылок из источников модели ещё можно перепроверить, то по изображению будет сложно понять, что оно "отравленное" до обучения модели.

Цель у разработчиков инструмента, конечно, благая - защита авторских прав и борьба с компаниями, которые используют работы художников для обучения моделей без разрешения правообладателей. Только метод был выбран разрушительный и его нужно будет учитывать при моделировании сценариев реализации угроз для систем, использующих искусственный интеллект.

#mlsecops